Jetson Nano は、カメラを装着して色々なものを認識させることが出来るため。実験のためには、持ち歩くことが出来ると便利です。小型タッチパネルモニタやモバイルバッテリー等で携帯可能なようにしたいと思います。

モバイル環境を構築してみる

レビュー比較等をした訳ではないですが、特に問題はなかったので以下に紹介します。

順番にJetson Nano本体、マウス&キーボードセット、Wifiトングル、9インチモニタ、Ankerモバイルバッテリーです。CSIカメラは、後で紹介します。

Jetson Nano と9インチモニタを接続する

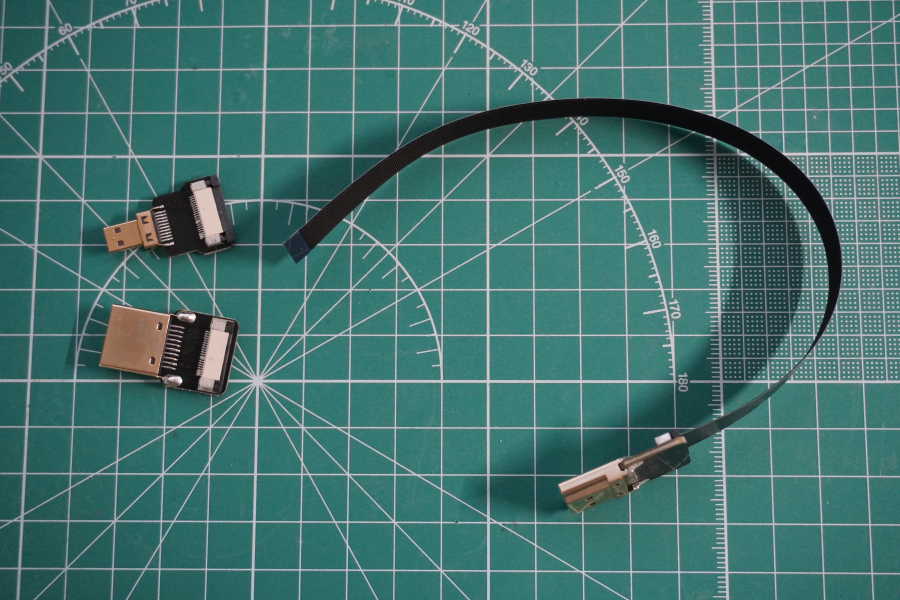

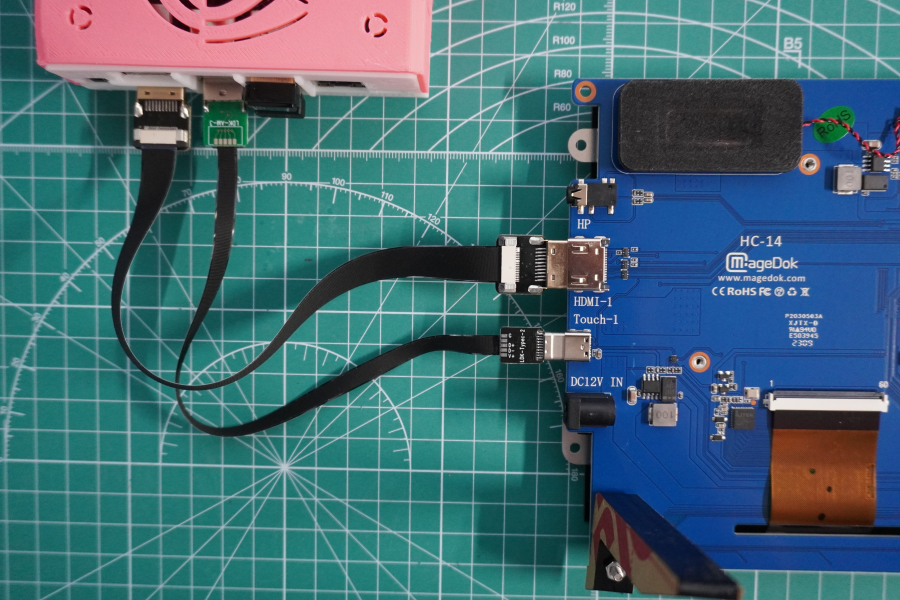

購入したJetson Nano 用の9インチモニタと接続します。普通のケーブルと接続することも可能でしたが、モニタにフラットケーブルが付属していたので短めのフラットケーブルにて接続を行ってみました。

上の写真のようにHDMIは、通常のモノとマイクロHDMIが接続してあり、Raspberry pi 用になっています。Jetoson Nano は通常&通常なので絶縁被覆ケーブルになっているものを利用するか、コネクタ部分の付け替えが必要になります。

また、USBについてもTypeA⇔TypeA、Type-C⇔Type-Cになっているため、フラットケーブル用にコネクタを入れ替えてType-A⇔Type-Cの2セットに変更しました。

HDMIについては、比較的すんなりとコネクタ交換が出来ましたが、USBについては、結構、悪戦苦闘しました。というのもコネクタの着脱が非常に難しく、硬かったため、壊れるのではないかと思いながら力いっぱい外しました。いずれも標準ポートと接続です。HDMIは映像出力、USBはタッチパッドとして利用できます。なお、モニタの電源は別途DC12Vが必要になります。

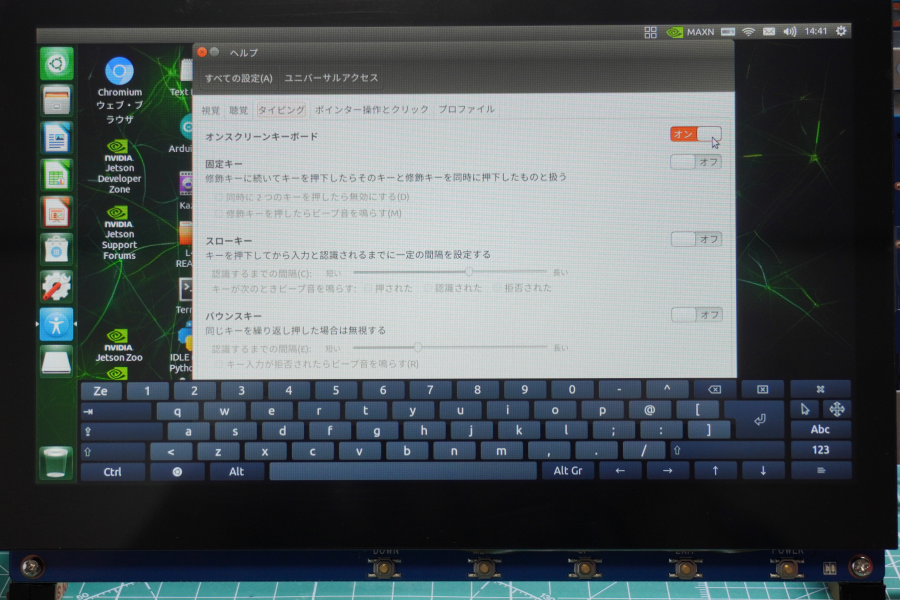

タッチパッドとして利用する際は、オンスクリーンキーボードを使うこともできます。

こんな感じになります。

IMX219 カメラモジュールを装着する

まずは、Raspberry Pi用のカメラを装着してみたのですが、認識しませんでした。どうも対応しているのは、カメラモジュールV2のみで、たまたま持っていたカメラモジュールV1とV3は、対応していないようです。

そこでJetson専用の以下のカメラを購入しました。Jetson nano B02モデルは、カメラコネクタが2つあるので2台購入して装着しました。(とはいっても1台しか使いませんが)

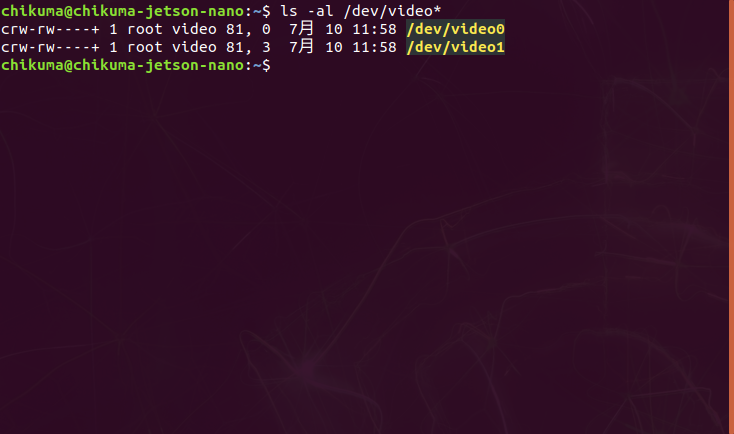

$ ls -al /dev/video*

Jetson Nano には、既にGStreamerフレームワークがインストールされているので、このツールを使って、まずはカメラの動作確認をしたいと思います。(これらのツールがGStreamerフレームワークに含まれているということしか分かっていません。)

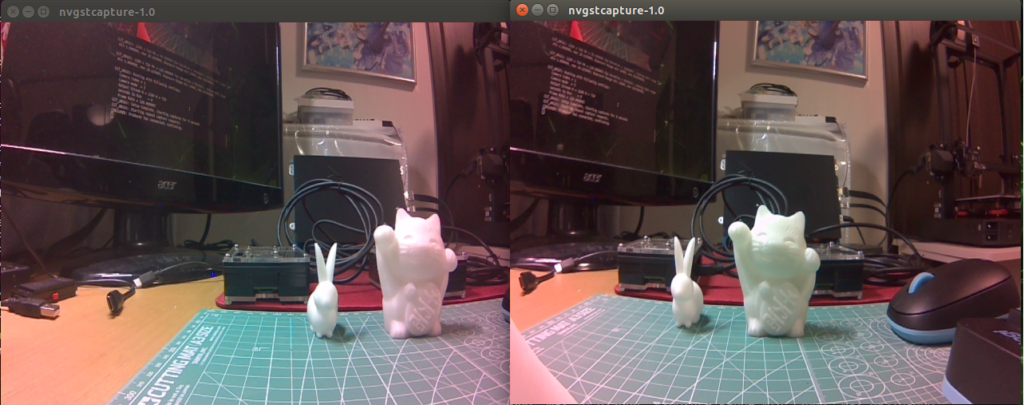

ツールに含まれるnvgstcaptureを使ってカメラの映像を画面に表示します。カメラを2台接続しているので2つのターミナルからnvgstcaptureを起動します。

$ nvgstcapture-1.0 --sensor-id=0$ nvgstcapture-1.0 --sensor-id=1

カメラをアイモックしてみる

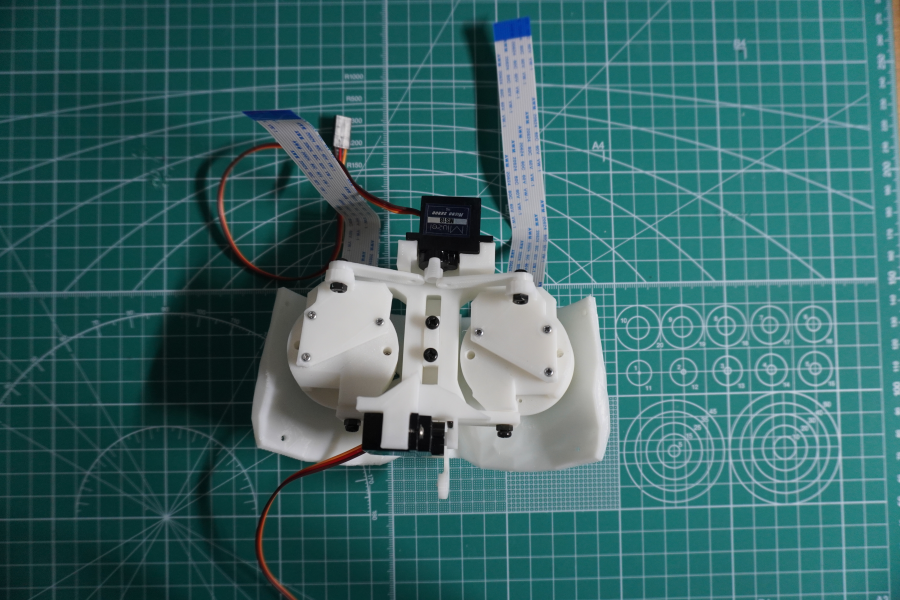

IMX219カメラモジュールをヒューマノイドロボットの眼に見えるようにモックしてみました。

元々は、InMoovのEye-mechanisumを参考にしています。3Dプリンタでカメラ取付部品を印刷して、IMX219にサイズが合わない部分は設計して印刷しました。

眼球を上下左右に動かせるようにマイクロサーボも取り付けていますが、サイズ調整が難しく今は動かすことが出来ません。他にも問題があり、JetsonNanoのGPIOで制御したいと考えていましたが、簡単には動かすことが出来ず、中断しています。代わりにArduinoを繋いでモータ制御してみましたが、サイズが合っていないので、動きませんでした。

ロボット制作で眼球を動かして、出来れば瞼も取り付けるようにしたいと思います。それは、また別の機会に掲載します。

黒目が大きくリアルで少し怖いですが、ステレオカメラになっています。今は試すことが出来ていませんが、距離測定、形状認識が出来る可能性を持っています。

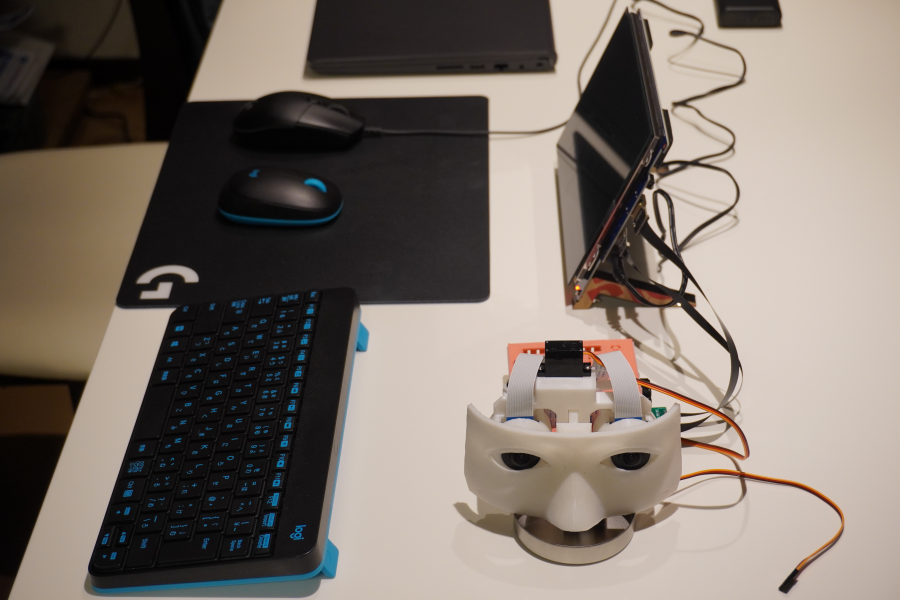

さて、全てを繋いだJetson Nano モバイルメカニズムです。

しかし、9インチモニタは、12V3Aという電力が必要なのでバッテリーでは駆動できていません。従って実際に外出で携帯するとなると、Jetson Nanoの制御は、Windowsモバイルでssh接続して行うことになりそうです。

以上

コメント